在线客服

扫描二维码

下载博学谷APP

扫描二维码

关注博学谷微信公众号

缓存是什么?为什么要使用缓存?缓存是将一些需要读取数据放在磁盘或者内存中,在读取数据的时一般是从关系型数据库中读取数据,缓存时能够最快提高服务响应速度的优化。

一、缓存是什么?

缓存就是将一些需要读取数据放在磁盘或者内存中,由于是追求速度,从而一般放在内存中。在读取数据的时候,一般是从关系型数据库中读取数据,在数据库层面也可以进行各种优化,例如读性能不足,那么可以添加几个从库,从而数据库的一主多从;例如写性能不足,那么可以分库分表。

在有些场景中,要使用缓存,是因为无法解决读的速度,例如count(*)的操作,无论从数据库的层面如何优化,都不可能提高;还有一种就是sql的执行本身就必须消耗很多资源和时间,例如各种关联查询子查询,这些时候,都可以将这些数据放在缓存当中,从而大大的减轻数据库的压力。

二、业务中为什么要使用缓存?

缓存时能够最快提高服务响应速度的优化,没有之一.

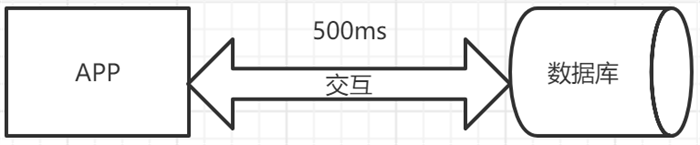

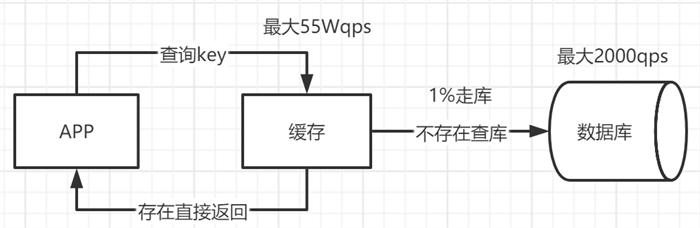

如上图的应用程序直接连接数据库进行查询操作,假如有一个操作过来需要500ms,并且每一次查询都需要经过数据库,性能非常低,并且对于数据库并发量支持非常不友好,如果并发量太多导致数据库压力太大可能导致数据库崩溃或者卡死。

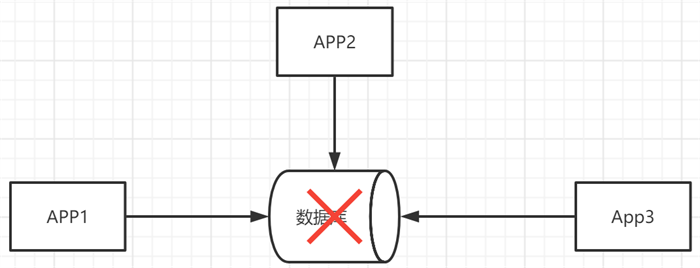

如果数据库崩溃,则依赖于数据库的其他应用都会无法运行。

1、高性能

这个是大部分使用缓存的目的,能够最快以非常高的效率提高应用的性能假设遇到一些查询速度很慢,比如权限,查询速度很慢,并且查询出来后很少发生变化,这种情况下大量查询对数据压力很大,并且性能不高。

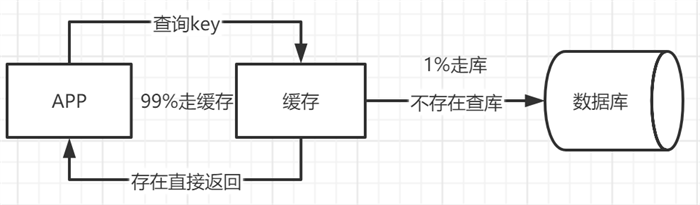

我们将缓存中的key保存到缓存中,然后在需要查询的时候直接查询缓存,而不走数据库,这样响应数据非常快,并且对于数据库的压力很小,一般缓存的查询都在微秒级,分布式缓存Redis中查询数据也在1ms中可以查询出来,这样在系统架构不进行大的变化的情况下完成了500倍的性能提升。

所以对于一些需要复杂操作耗时查出来的结果,确定后面不怎么变化,但是有很多读请求,直接将查询出来的结果放在缓存中,后面直接读缓存就好。

2、高并发

mysql 数据库对于高并发来说天然支持不好,mysql 单机支撑到 2000QPS 也开始容易报警了。

所以若是系统高峰期一秒钟有1万个请求,那么一个 mysql 单机绝对会死掉,这个时候就只能上缓存,把很多数据放入缓存,别放入 mysql,缓存功能简单,说白了就是 key-value 式操作,单机支撑的并发量一秒可达几万十几万,单机承载并发量是 mysql 单机的几十倍。

3、收益与成本

3.1收益

通过缓存加速读写速度:在内存中读写比硬盘速度快;降低数据库服务器的负载:比如业务端的请求的数据大多数都由Redis服务器来处理,大大减轻MySQL服务器的压力。

3.2 成本

数据不一致问题:比如Redis服务器与数据库服务器之间的某些数据可能会发生不一致问题,这是由两个服务器的数据更新策略不同引起的。

代码维护成本:需要添加数据缓存的逻辑代码;

运维成本:比如需要维护RedisCluster。

— 申请免费试学名额 —

在职想转行提升,担心学不会?根据个人情况规划学习路线,闯关式自适应学习模式保证学习效果

讲师一对一辅导,在线答疑解惑,指导就业!

相关推荐 更多

零基础大数据培训班课程怎么样?具体教些什么?

对于零基础想学大数据的小伙伴来说,在学习的道路上难免迷茫,因此选择一个好的培训机构是十分有必要的。博学谷针对基础薄弱的学员,专门开设了零基础大数据培训免费课程。那么课程到底怎么样?具体教些什么呢?该课程讲述hadoop的具体内容,是大数据学科的入门教程。上完该课程相信大家都能了解离线大数据处理的基本流程。现在让我们来看看具体课程安排吧!

8168

2019-08-06 11:07:51

物联网怎么保护云计算安全?

全球应用的物联网设备已经达到数十亿台,且数量不断增加。在开发和部署的许多物联网设备却缺乏关键的安全功能为黑客和僵尸网络的目标。没有适当的安全措施,物联网设备会导致灾难性事件。如何解决这些问题呢?

5621

2020-03-23 17:51:20

HDFS安全模式学习总结

众所周知,安全模式是HDFS所处的一种特殊状态,今天我们要来梳理一下关于HDFS安全模式的学习总结,主要内容包括安全模式概述、安全模式配置以及安全模式命令。下面赶紧开始吧~

5284

2020-06-05 17:05:28

大数据开发为什么要参加系统学习呢?

自从发展大数据产业被写入政府工作报告、BAT高薪聘请专业大数据人才之后,很多小白也开始纷纷转行进入大数据领域。很多的转型者都将参加培训机构看成是自己转型最高效的方式。

4615

2020-12-10 15:31:43

SaaS平台数据表单组件设计技巧分享

数据表单方法:固定表头、固定侧栏、自定义栏、分页器、过滤器、数据排序、多选项同时操作、简单且简约、普通的字体样式、项目链接、鼠标悬停设计指南,为大家提供有关数据表单设计的实用性建议。在实际的数据表单设计中还需要根据产品要求和用户目标进行相应的调整。

6012

2021-05-11 13:59:51