在线客服

扫描二维码

下载博学谷APP

扫描二维码

关注博学谷微信公众号

累加器和广播变量分别在什么场景使用?累加器分布式共享只写变量,如果在转换算子中调用累加器后续没有行动算子,累加器不会执行。后续如果调用了两次行动算子,会执行两次累加器出现多加的情况。

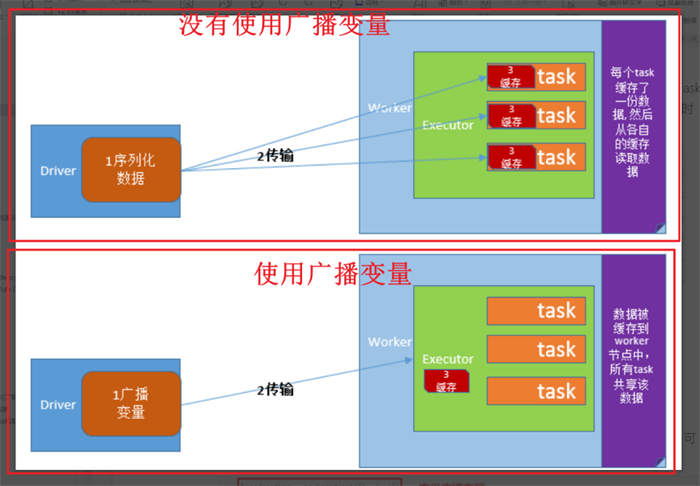

1、广播变量的使用方法介绍

解决的场景:

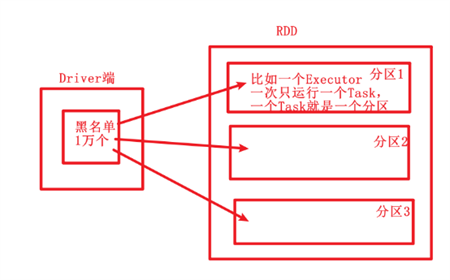

将Driver进程的共享数据发送给所有子节点Executor进程的每个任务中。如果不用广播变量技术,那么Driver端默认会将共享数据分发到每个【Task】中,造成网络分发压力大。

如果使用了广播变量技术,则Driver端将共享数据只会发送到每【Executor】一份。Executor中的所有【Task】都复用这个对象。要保证该共享对象是可【序列化】的。因为跨节点传输的数据都要是可序列化的。

在Driver端将共享对象广播到每个Executor:

val bc = sc.broadcast( 共享对象 )

在Executor中获取:

bc.value

2、累加器的使用方法介绍

集群中所有Executor对同一个变量进行累计操作。Spark目前只支持累【加】操作。有3种内置的累加器:【LongAccumulator】、【DoubleAccumulator】、【CollectionAccumulator】。

整数累加器使用方法

在Driver端定义整数累加器,赋初始值。

acc=sc.accumulator(0)

在Executor端每次累加1

acc+=1

或者acc.add(1)

3、综合案例

# -*- coding:utf-8 -*-

# Desc:This is Code Desc

from pyspark import SparkConf, SparkContext

import os

os.environ['SPARK_HOME'] = '/export/server/spark'

PYSPARK_PYTHON = "/root/anaconda3/bin/python3.8"

# 当存在多个版本时,不指定很可能会导致出错

os.environ["PYSPARK_PYTHON"] = PYSPARK_PYTHON

os.environ["PYSPARK_DRIVER_PYTHON"] = PYSPARK_PYTHON

if __name__ == '__main__':

#需求1:从大量用户中,剔除掉黑名单用户

conf=SparkConf().setAppName('sharevalue_review')\

.setMaster('local[*]')

sc=SparkContext(conf=conf)

sc.setLogLevel('WARN')

#创建大量用户

rdd_all=sc.parallelize(['zs','ls','ww','zl'])

#创建黑名单用户

black_list=['zs','ls']

#定义广播变量

bc=sc.broadcast(black_list)

#从大量用户中剔除掉黑名单用户

def filter_black(str):

#获取广播变量

black_list2=bc.value

if str in black_list2:

return False

else:

return True

filterd_rdd=rdd_all.filter(filter_black)

print('过滤后:')

print(filterd_rdd.collect())

#需求2:从大量数字中,挑选出带有7的数字,并计算他们的平均值。

#定义大量数字

rdd_all2=sc.parallelize(range(1,1001))

#定义累加器

#定义累加器1 ,记录有多少个7

acc = sc.accumulator(0)

#定义累加器2 ,将带有7的数字加起来

acc2=sc.accumulator(0)

def find7(i):

global acc

global acc2

if '7' in str(i):

acc+=1

acc2+=i

rdd2=rdd_all2.map(find7)

rdd2.count()

num_7=acc.value

sum_7=acc2.value

avg_7=sum_7/num_7

print('带有7数字的个数是',num_7,'他们的平均数是',avg_7)

小伙伴们一定要自己亲手敲代码进行练习,以上代码不仅练习了累加器和广播变量如何使用,还涉及了函数式编程(Map、Filter)如何使用,上下文变量如何创建、如何用并行化集合的方式创建RDD等,这些练习比较综合,希望可以帮助大家学到更多的技能。

— 申请免费试学名额 —

在职想转行提升,担心学不会?根据个人情况规划学习路线,闯关式自适应学习模式保证学习效果

讲师一对一辅导,在线答疑解惑,指导就业!

相关推荐 更多

零基础大数据培训班课程怎么样?具体教些什么?

对于零基础想学大数据的小伙伴来说,在学习的道路上难免迷茫,因此选择一个好的培训机构是十分有必要的。博学谷针对基础薄弱的学员,专门开设了零基础大数据培训免费课程。那么课程到底怎么样?具体教些什么呢?该课程讲述hadoop的具体内容,是大数据学科的入门教程。上完该课程相信大家都能了解离线大数据处理的基本流程。现在让我们来看看具体课程安排吧!

7173

2019-08-06 11:07:51

云计算和人工智能的两大误区是什么

云计算和人工智能的两大误区是什么?云计算和人工智能两大误区:云支出正在使数据中心支出大打折扣;人工智能过度炒作在很大程度上使企业购买者失败。过早采用人工智能可能会很有趣,但同时存在着诸多问题。

4710

2020-02-12 18:17:43

零基础能学大数据技术吗?学完能找到工作吗?

零基础能学大数据技术吗?学完能找到工作吗?随着大数据技术的普及,越来越多的企业将大数据定义到战略发展的层面,因此大数据技术岗位人才招聘呈现愈加明显的趋势。

5497

2020-08-24 14:24:01

大数据Hadoop生态体系中常见的子系统有哪些?

Hadoop是一个针对大量数据进行分布式处理的软件框架,是一个开发和运行处理大规模数据的软件平台,是Appach的一个用Java语言实现开源软件框架,实现在大量计算机组成的集群中对海量数据进行分布式计算,具有可靠、高效、可伸缩的特点,很多程序会用到这个框架。

4940

2021-03-17 13:58:05

如何获取大数据行业高薪岗位offer?

想要拿到高薪就要成为站在金字塔的人,在互联网行业需要保持不断的学习。学习大数据先思考自身未来想往哪个方向发展,想要入门快、基础深厚,并且需求多应用广建议从JAVA开始学起,找到适合自己的学习方法。

3778

2021-03-31 16:13:39

热门文章

- 前端是什么

- 前端开发的工作职责

- 前端开发需要会什么?先掌握这三大核心关键技术

- 前端开发的工作方向有哪些?

- 简历加分-4步写出HR想要的简历

- 程序员如何突击面试?两大招带你拿下面试官

- 程序员面试技巧

- 架构师的厉害之处竟然是这……

- 架构师书籍推荐

- 懂了这些,才能成为架构师 查看更多

扫描二维码,了解更多信息