在线客服

扫描二维码

下载博学谷APP

扫描二维码

关注博学谷微信公众号

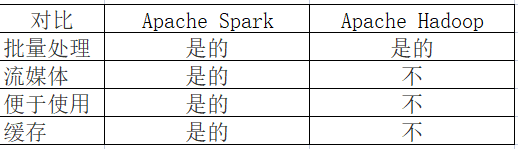

ApacheSpark与 Apache Hadoop数据科学工具有哪些区别?Apache Spark被设计为大规模处理的接口,而 Apache Hadoop 为大数据的分布式存储和处理提供了更广泛的软件框架。两者既可以一起使用也可以作为独立服务使用。Apache Spark 和 Apache Hadoop 都是 Apache 软件基金会提供的流行的开源数据科学工具,由社区开发和支持受欢迎程度和功能不断增长。

1、Apache Spark是什么?

Apache Spark 是一个为高效、大规模数据分析而构建的开源数据处理引擎。Apache Spark 是一个强大的统一分析引擎,数据科学家经常使用它来支持机器学习算法和复杂的数据分析。Apache Spark 可以独立运行,也可以作为 Apache Hadoop 之上的软件包运行。

2、Apache Hadoop是什么?

Apache Hadoop 是一组开源模块和实用程序,旨在简化存储、管理和分析大数据的过程。Apache Hadoop 的模块包括 Hadoop YARN、HadoopMapReduce 和 Hadoop Ozone,但它支持许多可选的数据科学软件包。Apache Hadoop 可以互换使用来指代 Apache Spark 和其他数据科学工具。

3、Apache Spark 与 Apache Hadoop有哪些区别

4、设计和架构区别

Apache Spark 是一个离散的开源数据处理实用程序。通过 Spark,开发人员可以访问用于数据处理集群编程的轻量级接口,具有内置的容错和数据并行性。Apache Spark 是用 Scala 编写的,主要用于机器学习应用程序。

Apache Hadoop 是一个更大的框架,其中包括 Apache Spark、Apache Pig、ApacheHive和 Apache Phoenix 等实用程序。作为一种更通用的解决方案,Apache Hadoop 为数据科学家提供了一个完整且强大的软件平台,然后他们可以根据个人需求进行扩展和定制。

5、使用范围

Apache Spark 的范围仅限于它自己的工具,包括 Spark Core、Spark SQL 和 Spark Streaming。Spark Core 提供了 Apache Spark 的大部分数据处理。Spark SQL支持额外的数据抽象层,开发人员可以通过它构建结构化和半结构化数据。Spark Streaming 利用 Spark Core 的调度服务来执行流分析。

Apache Hadoop 的范围要广泛得多。除了 Apache Spark,Apache Hadoop 的开源实用程序还包括pache Phoenix。一个大规模并行的关系数据库引擎。

(1)Apache Zookeeper.。用于云应用程序的协调分布式服务器。

(2)pache Hive。用于数据查询和分析的数据仓库。

(3)Apache Flume。分布式日志数据的仓储解决方案。

但是出于数据科学的目的,并非所有应用程序都如此广泛。速度、延迟和强大的处理能力在大数据处理和分析领域中至关重要——独立安装的 Apache Spark 可能更容易提供这些。

6、速度

对于大多数实现,Apache Spark 将比 Apache Hadoop 快得多。Apache Spark 专为速度而打造,其速度可能比 Apache Hadoop 快近 100 倍。然而,这是因为 Apache Spark 更简单、更轻量级。

默认情况下,Apache Hadoop 不会像 Apache Spark 一样快。但是,其性能可能会因安装的软件包以及所涉及的数据存储、维护和分析工作而异。

7、学习曲线

由于其关注点相对狭窄,Apache Spark 更容易学习。Apache Spark 有一些核心模块,并为数据的操作和分析提供了一个干净、简单的界面。由于 Apache Spark 是一个相当简单的产品,因此学习曲线很短。

Apache Hadoop 要复杂得多。参与的难度将取决于开发人员如何安装和配置 Apache Hadoop 以及开发人员选择包含哪些软件包。无论如何,即使开箱即用,Apache Hadoop 的学习曲线也更为显著。

8、安全性和容错性

当作为独立产品安装时,Apache Spark 的开箱即用安全性和容错功能少于 Apache Hadoop。但是,Apache Spark 可以访问许多与 Apache Hadoop 相同的安全实用程序,例如 Kerberos 身份验证——它们只需要安装和配置即可。

Apache Hadoop 具有更广泛的本机安全模型,并且在设计上具有广泛的容错性。与 Apache Spark 一样,它的安全性可以通过其他 Apache 实用程序进一步提高。

9、编程语言

Apache Spark 支持 Scala、Java、SQL、Python、R、C# 和 F#。它最初是在 Scala 中开发的。Apache Spark 支持数据科学家使用的几乎所有流行语言。

Apache Hadoop 是用 Java 编写的,部分是用 C 编写的。Apache Hadoop 实用程序支持其他语言,使其适合所有技能的数据科学家。

10、在 Apache Spark 与 Hadoop 之间进行选择

如果您是主要从事机器学习算法和大规模数据处理的数据科学家,请选择 Apache Spark。

Apache Spark:

(1)在没有 Apache Hadoop 的情况下作为独立实用程序运行。

(2)提供分布式任务调度、I/O功能和调度。

(3)支持多种语言,包括 Java、Python 和 Scala。

(4)提供隐式数据并行性和容错性。

如果您是需要大量数据科学实用程序来存储和处理大数据的数据科学家,请选择 Apache Hadoop。

Apache Hadoop:

(1)为大数据的存储和处理提供广泛的框架。

(2)提供了一系列令人难以置信的软件包,包括 Apache Spark。

(3)建立在分布式、可扩展和可移植的文件系统之上。

(4)利用其他应用程序进行数据仓库、机器学习和并行处理。

— 申请免费试学名额 —

在职想转行提升,担心学不会?根据个人情况规划学习路线,闯关式自适应学习模式保证学习效果

讲师一对一辅导,在线答疑解惑,指导就业!

相关推荐 更多

大数据HIve数据仓库应用案例讲解分析

如今,大数据的大浪已经把我们每个人都卷入其中,随着大数据技术一起引起大众注意的还有HIve数据仓库。作为大数据分析的核心工具之一,它一直发挥着为企业提供决策支持的重要作用。因此掌握Hive是入门大数据学习的关键之一,下面我们就一起来看看HIve数据仓库应用案例讲解。

7266

2019-09-20 16:55:35

HDFS入门基础学习总结

HDFS全称就是Hadoop分布式文件系统,作为Hadoop的核心组件,它提供了最底层的分布式存储服务。本文整理了HDFS设计目标和HDFS的重要特性等等内容,下面一起来看HDFS入门基础学习总结吧~

4871

2020-06-09 16:19:01

学大数据一定要学Java编程语言吗?

大数据相关岗位的就业薪资和发展前景,吸引了许多人纷纷参加培训机构以谋求一个就业机会。考察各个培训机构的课程,我们不难发现,不管哪个大数据培训机构的课程都涉及Java编程语言的学习。那么,学大数据一定要学Java编程语言吗?答案是不一定,如果你想从事大数据开发岗位,那一定要学Java编程语言。如果只是想往数据分析方向发展,那么学Python就足够了。

5634

2020-06-30 18:38:45

大数据对教育行业重要作用有哪些?

大数据通过更好的决策、评估和增强的学习成果影响教育体系,有助于教育工作者跟踪学生的表现,并为其提供更好的学习环境。学生将不再受到静态学习计划的限制。若教育工作者广泛采用大数据系统,能够将学习过程提高到一个新水平。

9902

2021-02-04 15:16:33

工信部测算到2025年中国大数据产业规模将突破3万亿元

工信部测算到2025年中国大数据产业规模将突破3万亿元,全球互联网、大数据、云计算、数字孪生、元宇宙等数字技术加速创新趋势,探讨数字科技革命和产业变革的新机遇,聚焦大数据与实体经济、社会治理、民生服务、乡村振兴的深度融合,发布一批大数据创新应用场景,探讨共享应用场景创新的价值。

2629

2022-06-09 15:29:53